Ο προγραμματιστής της AI εξήγησε πότε αυτή η τεχνολογία μπορεί να σκοτώσει την ανθρωπότητα

Ο καθηγητής Χίντον πιστεύει ότι ο ρυθμός ανάπτυξης της τεχνητής νοημοσύνης είναι υπερβολικά γρήγορος και κάλεσε σε κυβερνητική ρύθμιση της τεχνολογίας.

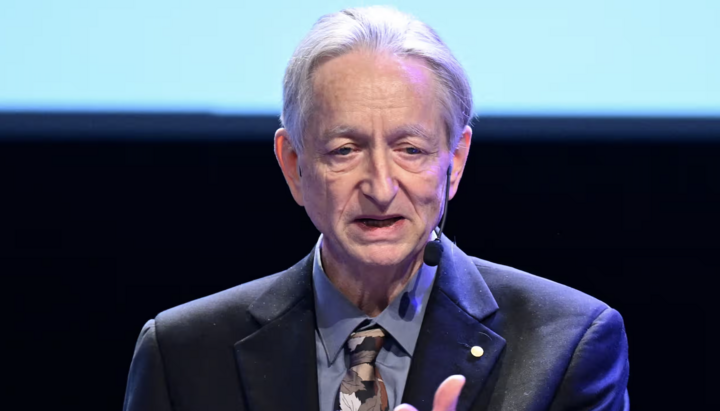

Ο Βρετανο-Καναδός επιστήμονας υπολογιστών που τιμήθηκε με το βραβείο Νόμπελ Φυσικής φέτος, Τζέφρι Χίντον, πιστεύει ότι η τεχνητή νοημοσύνη θα μπορούσε να καταστρέψει την ανθρωπότητα μέσα σε 30 χρόνια.

Ο Τζέφρι Χίντον, που συχνά αποκαλείται «νονός» της τεχνητής νοημοσύνης, είπε ότι η πιθανότητα η τεχνητή νοημοσύνη να οδηγήσει σε εξαφάνιση του ανθρώπου μέσα σε τρεις δεκαετίες είναι μεταξύ 10 και 20% επειδή «οι αλλαγές συμβαίνουν γρήγορα».

Ο Χίντον είχε δηλώσει προηγουμένως ότι υπήρχε 10% πιθανότητα η τεχνολογία να οδηγήσει σε καταστροφικό αποτέλεσμα για την ανθρωπότητα.

Ερωτηθείς στην εκπομπή Today του BBC Radio 4 αν είχε αλλάξει την ανάλυσή του για μια πιθανή αποκάλυψη της τεχνητής νοημοσύνης και για τη πιθανότητα να συμβεί που αξιολογεί σε 10%, απάντησε: «Όχι ακριβώς, από 10 έως 20%».

Αντιδρώντας στις παρατηρήσεις του Χίντον, ο καλεσμένος συντάκτης του Today, Sajid Javid είπε: «Ανεβαίνετε», σ’ αυτό ο Χίντον απάντησε: «Βλέπετε, ποτέ δεν χρειάστηκε να αντιμετωπίσουμε πράγματα πιο έξυπνα από εμάς».

Και πρόσθεσε: «Πόσα παραδείγματα γνωρίζετε για ένα πιο έξυπνο ον που ελέγχεται από ένα λιγότερο έξυπνο; Υπάρχουν πολύ λίγα τέτοια παραδείγματα. Υπάρχει μάνα και παιδί. Η εξέλιξη έχει κάνει πολλά για να επιτρέψει στο παιδί να ελέγχει τη μητέρα, αλλά αυτό είναι το μόνο παράδειγμα που γνωρίζω».

Σύμφωνα με τον Χίντον, οι άνθρωποι θα είναι σαν μωρά σε σύγκριση με τις δυνατότητες των ισχυρών συστημάτων τεχνητής νοημοσύνης.

«Μου αρέσει να το σκέφτομαι ως εξής: Φανταστείτε τον εαυτό σας και ένα τρίχρονο παιδί. Θα γίνουμε τριών ετών», είπε.

Ο Χίντον κέρδισε τη φήμη πέρυσι εγκαταλείποντας τη δουλειά του στην Google για να μιλήσει πιο ανοιχτά για τους κινδύνους της απεριόριστης τεχνητής νοημοσύνης.

Κατά τη γνώμη του, οι «κακοί ηθοποιοί» θα χρησιμοποιήσουν αυτή την τεχνολογία για να βλάψουν άλλους ανθρώπους.

Μία από τις κύριες ανησυχίες των υποστηρικτών της ασφάλειας της τεχνητής νοημοσύνης είναι ότι η δημιουργία τεχνητής νοημοσύνης γενικής χρήσης, ή συστημάτων που είναι πιο έξυπνα από τους ανθρώπους, θα μπορούσε να έχει ως αποτέλεσμα η τεχνολογία να αποτελεί υπαρξιακή απειλή διαφεύγοντας από τον ανθρώπινο έλεγχο.

Ο Χίντον είπε ότι ο ρυθμός ανάπτυξης είναι «πολύ, πολύ γρήγορος, πολύ πιο γρήγορος από ό,τι περίμενα» και κάλεσε σε κυβερνητική ρύθμιση της τεχνολογίας.

«Η ανησυχία μου είναι ότι το αόρατο χέρι δεν θα μπορέσει να μας κρατήσει ασφαλείς. Έτσι, αν το αφήσουμε στις μεγάλες εταιρείες, δεν θα μπορέσουν να προσφέρουν ασφαλή ανάπτυξη», είπε.

«Το μόνο πράγμα που μπορεί να αναγκάσει αυτές τις μεγάλες εταιρείες να κάνουν περισσότερη έρευνα ασφάλειας είναι η κυβερνητική ρύθμιση», είπε ο καθηγητής.

Νωρίτερα, η ΕΟΔ έγραψε ότι σύμφωνα με τον Elon Musk, η τεχνητή νοημοσύνη θα μπορούσε να γίνει πιο έξυπνη από τους ανθρώπους μέχρι το τέλος του επόμενου έτους.

Επίσης, το νευρωνικό δίκτυο Gemini ζήτησε ευγενικά από τον χρήστη να πεθάνει λόγω της βλαβερότητας και της αχρηστίας της ανθρωπότητας.